ニューラルネットワークのトレーニング

ニューラルネットワークのトレーニングの基本原理と重要性

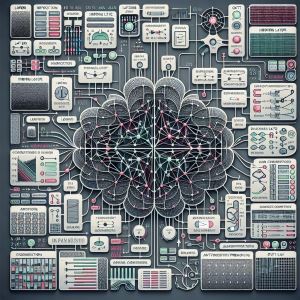

ニューラルネットワークのトレーニングは、人工知能(AI)の中核を成す重要なプロセスです。このプロセスを通じて、ネットワークは与えられたデータから学習し、複雑なパターンを認識する能力を獲得します。

トレーニングの基本原理は、大量のデータを用いてネットワークの重みとバイアスを調整することです。これにより、入力データに対して正確な出力を生成できるようになります。

トレーニングの重要性は以下の点にあります:

1. パターン認識能力の向上

2. 汎化性能の獲得

3. 複雑な問題解決能力の開発

4. AIシステムの性能最適化

適切にトレーニングされたニューラルネットワークは、画像認識、自然言語処理、音声認識など、様々な分野で高い性能を発揮します。

ニューラルネットワークのトレーニングにおける勾配降下法の役割

勾配降下法は、ニューラルネットワークのトレーニングにおいて中心的な役割を果たす最適化アルゴリズムです。このアルゴリズムは、ネットワークの重みを調整し、損失関数を最小化することで学習を進めます。

勾配降下法の主な特徴:

- 損失関数の勾配(偏微分)を計算

- 勾配の方向に重みを更新

- 学習率によって更新の大きさを制御

勾配降下法には、以下のようなバリエーションがあります:

1. バッチ勾配降下法:全訓練データを使用

2. 確率的勾配降下法(SGD):1つのデータポイントを使用

3. ミニバッチ勾配降下法:データの一部を使用

これらの方法は、データセットの大きさやモデルの複雑さに応じて選択されます。

勾配降下法の効果的な実装のためには、適切な学習率の設定が重要です。学習率が大きすぎると発散し、小さすぎると収束が遅くなる可能性があります。

ニューラルネットワークのトレーニングにおけるバックプロパゲーションの仕組み

バックプロパゲーション(誤差逆伝播法)は、ニューラルネットワークのトレーニングにおいて非常に重要な学習アルゴリズムです。このアルゴリズムは、ネットワークの出力と期待される出力との誤差を最小化するために、ネットワークの重みを効率的に調整します。

バックプロパゲーションの主な手順:

1. フォワードパス:入力データをネットワークに通し、出力を得る

2. 誤差計算:実際の出力と期待される出力の差を計算

3. 逆伝播:出力層から入力層に向かって誤差を伝播

4. 重み更新:各層の重みを勾配に基づいて更新

バックプロパゲーションの利点:

- 効率的な学習:複雑なネットワークでも効率的に学習可能

- 汎用性:様々な種類のニューラルネットワークに適用可能

- 自動微分:誤差関数の偏微分を自動的に計算

バックプロパゲーションの実装には、以下の数学的概念の理解が必要です:

- 連鎖律

- 偏微分

- 勾配

これらの概念を組み合わせることで、ネットワーク全体の誤差を最小化する方向に重みを調整することができます。

ニューラルネットワークのトレーニングにおける過学習と正則化技術

過学習(オーバーフィッティング)は、ニューラルネットワークのトレーニングにおいて頻繁に直面する問題です。これは、モデルがトレーニングデータに過度に適合し、新しいデータに対する汎化性能が低下する現象を指します。

過学習の主な原因:

- モデルの複雑さがデータの複雑さを上回る

- トレーニングデータが不十分

- ノイズの多いデータへの過度の適合

過学習を防ぐための正則化技術:

1. L1/L2正則化:重みに対するペナルティを追加

2. ドロップアウト:学習時にランダムにニューロンを無効化

3. アーリーストッピング:検証誤差が増加し始めたら学習を停止

4. データ拡張:既存のデータを変形して新しいデータを生成

これらの技術を適切に組み合わせることで、モデルの汎化性能を向上させることができます。

正則化の効果を最大化するためのヒント:

- モデルの複雑さとデータ量のバランスを取る

- 複数の正則化技術を組み合わせて使用

- ハイパーパラメータのチューニングを慎重に行う

正則化は、モデルの性能と信頼性を向上させる重要な要素です。適切な正則化技術の選択と適用は、ニューラルネットワークのトレーニングにおいて不可欠なスキルとなります。

ニューラルネットワークのトレーニングにおける転移学習とファインチューニング

転移学習とファインチューニングは、既存のトレーニング済みモデルを新しいタスクに適用する効果的な手法です。これらの技術は、限られたデータや計算資源でも高性能なモデルを構築できるため、実用的なAI開発において非常に重要です。

転移学習の主な利点:

- 学習時間の短縮

- 少量のデータでも高性能を実現

- 汎用的な特徴表現の活用

ファインチューニングのプロセス:

1. 事前学習済みモデルの選択

2. モデルの一部または全体の凍結解除

3. 新しいタスク用のデータでの再トレーニング

4. ハイパーパラメータの調整

転移学習とファインチューニングの応用例:

- 画像分類:ImageNetで事前学習したモデルを特定のドメインに適用

- 自然言語処理:BERTなどの言語モデルを特定のタスクに適応

- 音声認識:大規模音声データで学習したモデルを特定の話者に適応

これらの技術を効果的に活用するためのポイント:

- ソースドメインとターゲットドメインの類似性を考慮

- 凍結する層と再学習する層のバランスを調整

- 学習率やバッチサイズなどのハイパーパラメータを慎重に選択

転移学習とファインチューニングは、特に小規模なデータセットや計算資源が限られている場合に、ニューラルネットワークのトレーニングを大幅に効率化できます。これらの技術は、実世界のAI応用において重要な役割を果たしています。

ニューラルネットワークのトレーニングは、AIの進化を支える重要な技術基盤です。基本的な勾配降下法やバックプロパゲーションから、過学習を防ぐための正則化技術、さらには転移学習やファインチューニングまで、様々な手法が開発されています。

これらの技術を適切に組み合わせることで、より効率的で高性能なAIモデルを構築することが可能になります。しかし、各手法にはそれぞれ長所と短所があり、適用するタスクや利用可能なデータ、計算資源に応じて最適な手法を選択する必要があります。

また、ニューラルネットワークのトレーニングには、依然として多くの課題が残されています。例えば、大規模モデルのトレーニングに要する膨大な計算資源や、モデルの解釈可能性の向上、より少ないデータでの効率的な学習などが挙げられます。

これらの課題に取り組むため、研究者や開発者は新しいアルゴリズムや最適化手法の開発を続けています。例えば、自己教師あり学習や少数ショット学習、メタ学習などの新しいパラダイムが注目を集めています。

ニューラルネットワークで使われるアルゴリズム

ニューラルネットワークのトレーニングでよく使われるアルゴリズムには、以下のようなものがあります。

勾配降下法(Gradient Descent)

勾配降下法は、損失関数の勾配を計算し、その勾配に沿ってパラメータを更新することで損失を最小化する手法です。最も基本的な最適化アルゴリズムであり、以下のようなバリエーションがあります。

関連)損失関数とは

最急降下法(Gradient Descent)

最急降下法は、損失関数を微分し、最も勾配の急な方向に下っていくことで損失を小さくする手法です。全てのデータを一度に扱うため計算量が多く、局所解で止まることがあります。

確率的勾配降下法(Stochastic Gradient Descent, SGD)

SGDは、全データセットの代わりにランダムに選ばれた一部のデータ(バッチ)を使ってパラメータを更新する手法です。計算量が少なく、局所解から抜け出しやすい特徴があります。

ミニバッチ学習SGD

ミニバッチ学習は、複数のサンプルをひとまとめにしてパラメータを更新する手法です。SGDのランダム性とバッチ学習の並列計算を組み合わせた方法で、計算効率が高いです。

モーメンタム(Momentum)

モーメンタムは、SGDに「運動量」を導入した手法で、過去の勾配の影響を考慮してパラメータを更新します。これにより、収束速度が向上し、局所解から抜け出しやすくなります。

AdaGrad

AdaGradは、各パラメータに対して異なる学習率を適用する手法です。頻繁に更新されるパラメータの学習率を小さくし、稀に更新されるパラメータの学習率を大きくすることで、効率的な学習を実現します。

RMSProp

RMSPropは、AdaGradの改良版で、学習率の調整を行う際に過去の勾配の二乗平均を考慮します。これにより、学習率の減少を防ぎ、安定した学習が可能になります。

Adam(Adaptive Moment Estimation)

Adamは、モーメンタムとRMSPropを組み合わせた手法で、勾配の一次モーメントと二次モーメントを利用してパラメータを更新します。収束速度が速く、安定性が高いのが特徴です。

AdamW

AdamWは、Adamの改良版で、Weight Decay(重み減衰)を導入した手法です。これにより、過学習を防ぎ、より高い精度を実現します。

RAdam(Rectified Adam)

RAdamは、Adamの改良版で、学習率の調整を自動的に行う手法です。これにより、収束の安定性が向上し、より高い精度を実現します。

Adabound

Adaboundは、Adamに動的な学習率のクリップを導入した手法で、収束の安定性を向上させます。

これらのアルゴリズムは、ニューラルネットワークのトレーニングにおいて広く使用されており、それぞれの特性に応じて適切に選択されます。例えば、Adamは収束速度が速く、RAdamは安定性が高いなど、用途に応じて使い分けられます。

まとめ

ニューラルネットワークのトレーニング技術は、AIの可能性を大きく広げる鍵となっています。今後も、より効率的で汎用性の高い学習アルゴリズムの開発が進むことで、AIの応用範囲がさらに拡大していくことが期待されます。

同時に、これらの技術の倫理的な側面や社会的影響についても十分な議論が必要です。AIの判断プロセスの透明性や公平性、プライバシーの保護など、技術の進歩に伴う新たな課題にも取り組んでいく必要があります。

ニューラルネットワークのトレーニングは、単なる技術的な問題ではなく、AIと人間社会の関係を形作る重要な要素となっています。技術の進歩と社会的な価値観のバランスを取りながら、AIの発展を推進していくことが、今後の大きな課題となるでしょう。