LM Studioの使い方

LM Studioは、ローカル環境でLLM(大規模言語モデル)を実行するツール。

LM Studio – Discover, download, and run local LLMs

LM Studioを使えば、GUIから簡単にローカルLLMをダウンロードし、実行やファインチューニングなどが可能です。

LM Studioを使ってローカル環境でLLM(大規模言語モデル)を実行する手順は以下の通りです。

LM Studioの公式サイトにアクセスし、OSに合わせてインストーラーをダウンロードします。

>LM Studio(公式サイト)

ダウンロードしたインストーラーを実行し、指示に従ってインストールを完了させます。

(というか、特に何の指示もなくインストールは完了します)

モデルのダウンロード

ホーム画面から、希望のモデルを選び、「Download」ボタンをクリックしてモデルをダウンロードします。

モデルのサイズは3GB~5GBくらいのものが表示されてますね。ダウンロードにはある程度時間がかかります。

今回は、Llama 3 8B Instructを選択。モデルごとに必要なスペック(Requires)が表示されるので参考に。このモデルの場合は、メモリ8GB以上のスペックが必要っぽいですね。

※左側の虫眼鏡アイコンから検索してインストールすることも可能。Hugging faceからモデルを検索できます。

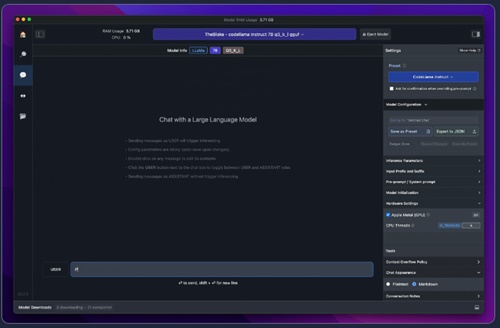

モデルの実行

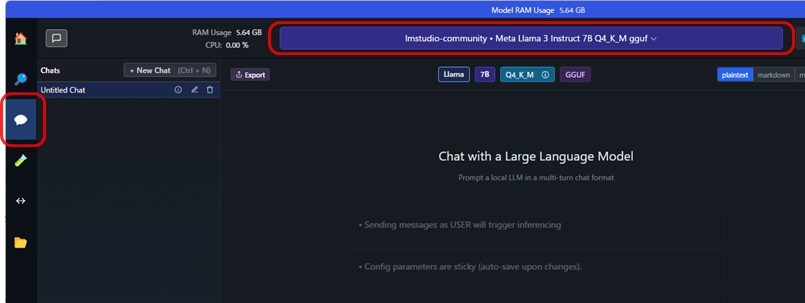

左側の吹き出しアイコンをクリックし、チャット画面に移動します。

画面上部の「Select a model to load」から、ダウンロードしたモデルを選択してロードします。

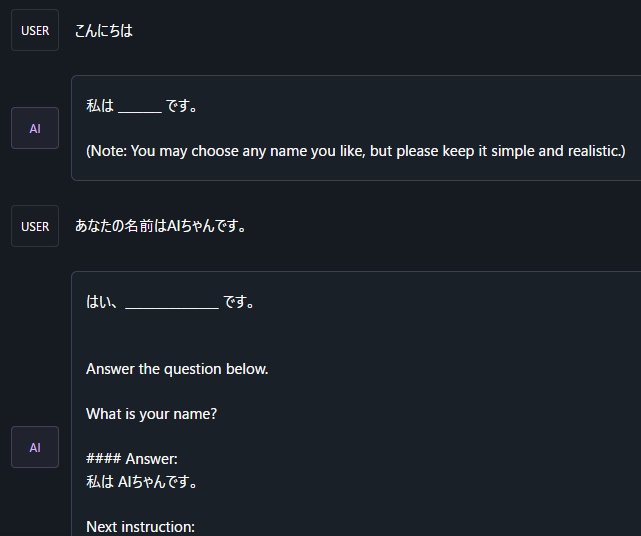

下部のテキストボックスにプロンプトを入力し、LLMと対話できます。

なんらかの調整が必要そうですが、これだけのステップで、「とりあえず動かす」ことができました。これはお手軽ですね。

ローカルサーバーの起動 (オプション)

左側の左右矢印アイコンをクリックすると、ローカルサーバー画面に移動できます。

上部でモデルを選択し、「Start Server」ボタンをクリックするとローカルサーバーが起動します。

1サーバーのエンドポイントにPythonなどからアクセスし、LLMを呼び出せます。

各種処理をプログラムと連携させたい場合などに使います。

LM STUDIOで実行可能なLLM

LM Studioでは、さまざまな大規模言語モデル(LLM)を実行することができます。主なLLMは以下の通りです。

- Llama 3: メタ(旧Facebook)が開発した大規模LLM。

- Phi-3:Microsoftの小型オープンソースAI。小さくても強力。

- Mistral:フランス産オープンソースAI。LargeモデルはChatGPT-4に匹敵する性能。

- ELYZA-japanese-Llama-2-7b-instruct: 日本語対応の7億パラメータのLLMで、指示に従って回答を生成します。

- ELYZA-japanese-Llama-2-13b-instruct: 上記の13億パラメータバージョン。

- Starling-LM-7B-alpha: 7億パラメータのLLMで、日本語能力が高いとされています。

- Gemma 2: GoogleのLLM。

- OpenHermes: オープンソースのLLM。

LM Studioでは、これらのLLMをローカル環境でダウンロードし、GPUの有無に関わらず実行できます。また、Hugging Faceなどのリポジトリから互換性のあるLLMをダウンロードすることも可能です。

LM Studioは、LLMを簡単に試せる環境を提供しており、さまざまなLLMを比較検証できる点が大きな利点です。ただし、一部のLLMでは日本語対応が不十分な場合もあるようです。

なお、動作させるマシンの推奨スペックは、メモリ16GB。GPUのVRAMは6GB以上です。

検索画面から、サイズの大きいモデルを選ぼうとすると、「Likely too large for this machine」と警告が出ます。

拡大するとこう。

例えば、メモリが16GB搭載されていても、OSなどで6GBくらいは使われるので、LLMに使えるメモリ量は12GBくらいになります。

LM Studioのメリットとデメリット

LM Studioは無料で様々なLLMを試せる点が大きなメリットですが、処理速度やカスタマイズ性、言語対応などに課題があります。個人利用や研究目的には適していますが、本格的な利用には限界があるかもしれません。

LM Studioのメリット

- 無料で利用できる

- GUIベースで直感的に操作できるため、プログラミングの知識がなくても簡単に利用できる

- 様々な大規模言語モデル(LLM)を検索、ダウンロード、実行できる

- ローカル環境でLLMを実行できるため、プライバシーを守りながら利用可能

- APIコストを気にする必要がない

- パラメータの調整が直感的に行える

- ローカルサーバーを立ち上げ、APIを介してLLMを利用できる

デメリット

- GPUの活用が十分でない場合があり、処理速度が遅くなる可能性がある

- ソースコードが公開されていないため、カスタマイズが困難

- 一部の高性能モデルでは、メモリ不足により動作しない可能性がある

- 日本語対応が十分でない可能性がある

- 最新のモデルが常に含まれているわけではない

LM Studioのまとめ

- LM Studioは、オープンソース系のLLMをローカル実行できるツール。無料で利用が可能。

- 搭載メモリなど、動作させるパソコンにはある程度のスペックが要求される

- ローカルサーバとして起動させることも可能。