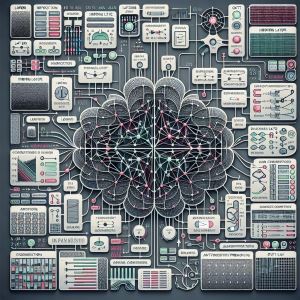

ニューラルネットワークのトレーニング

ニューラルネットワークのトレーニングでよく使われるアルゴリズムには、以下のようなものがあります。

勾配降下法(Gradient Descent)

勾配降下法は、損失関数の勾配を計算し、その勾配に沿ってパラメータを更新することで損失を最小化する手法です。最も基本的な最適化アルゴリズムであり、以下のようなバリエーションがあります。

関連)損失関数とは

最急降下法(Gradient Descent)

最急降下法は、損失関数を微分し、最も勾配の急な方向に下っていくことで損失を小さくする手法です。全てのデータを一度に扱うため計算量が多く、局所解で止まることがあります。

確率的勾配降下法(Stochastic Gradient Descent, SGD)

SGDは、全データセットの代わりにランダムに選ばれた一部のデータ(バッチ)を使ってパラメータを更新する手法です。計算量が少なく、局所解から抜け出しやすい特徴があります。

ミニバッチ学習SGD

ミニバッチ学習は、複数のサンプルをひとまとめにしてパラメータを更新する手法です。SGDのランダム性とバッチ学習の並列計算を組み合わせた方法で、計算効率が高いです。

モーメンタム(Momentum)

モーメンタムは、SGDに「運動量」を導入した手法で、過去の勾配の影響を考慮してパラメータを更新します。これにより、収束速度が向上し、局所解から抜け出しやすくなります。

AdaGrad

AdaGradは、各パラメータに対して異なる学習率を適用する手法です。頻繁に更新されるパラメータの学習率を小さくし、稀に更新されるパラメータの学習率を大きくすることで、効率的な学習を実現します。

RMSProp

RMSPropは、AdaGradの改良版で、学習率の調整を行う際に過去の勾配の二乗平均を考慮します。これにより、学習率の減少を防ぎ、安定した学習が可能になります。

Adam(Adaptive Moment Estimation)

Adamは、モーメンタムとRMSPropを組み合わせた手法で、勾配の一次モーメントと二次モーメントを利用してパラメータを更新します。収束速度が速く、安定性が高いのが特徴です。

AdamW

AdamWは、Adamの改良版で、Weight Decay(重み減衰)を導入した手法です。これにより、過学習を防ぎ、より高い精度を実現します。

RAdam(Rectified Adam)

RAdamは、Adamの改良版で、学習率の調整を自動的に行う手法です。これにより、収束の安定性が向上し、より高い精度を実現します。

Adabound

Adaboundは、Adamに動的な学習率のクリップを導入した手法で、収束の安定性を向上させます。

これらのアルゴリズムは、ニューラルネットワークのトレーニングにおいて広く使用されており、それぞれの特性に応じて適切に選択されます。例えば、Adamは収束速度が速く、RAdamは安定性が高いなど、用途に応じて使い分けられます。