LLMのランキング

LLMのランキング変動は激しい。新しいLLMもどんどん生まれていく…。2024年6月のランキングはこれ。

Chat with Open Large Language Models

LLMのランキングを可視化しているのがこれ。2023~2024年の変動グラフ。(https://chat.lmsys.org/)

I used the chatbot arena data from @lmsysorg to create a visualization of LLM’s Elo rating changes. You can see:

1. The gap between various companies/open source projects is narrowing.

2. The major players are gradually becoming the various big tech companies. pic.twitter.com/4JaJsYljLM— Jianqi Pan (@jannchie) April 28, 2024

LLMの特徴

- 膨大なテキストデータを用いて学習された、自然言語処理のための深層学習モデル

関連 word2vecの学習済みモデル - 数十億から数兆のパラメータを持つ非常に大規模なニューラルネットワーク

- 文章生成、要約、翻訳、感情分析、質問応答など、様々なタスクに応用可能

- 学習データが増えるほど性能が向上し、少数のサンプルから新しいタスクを学習できる

LLMの仕組み

- Transformerと呼ばれるニューラルネットワークアーキテクチャを基盤としている

関連 多層パーセプトロン(MLP)とは - 大量のテキストデータから単語の関係性や文脈を学習

- ファインチューニングやプロンプトチューニングにより特定のタスクに最適化

LLMの応用例

- ChatGPTなどの対話型AI

- プログラミングの自動化やコード生成

- 医療や科学分野での知識発見の加速

- 多言語翻訳による言語の壁の解消

LLMは自然言語処理の分野に大きな変革をもたらしつつあり、ビジネスや社会に幅広い影響を与えると期待されています。一方で、偏見やプライバシーの問題など、倫理的な課題にも留意が必要とされています。

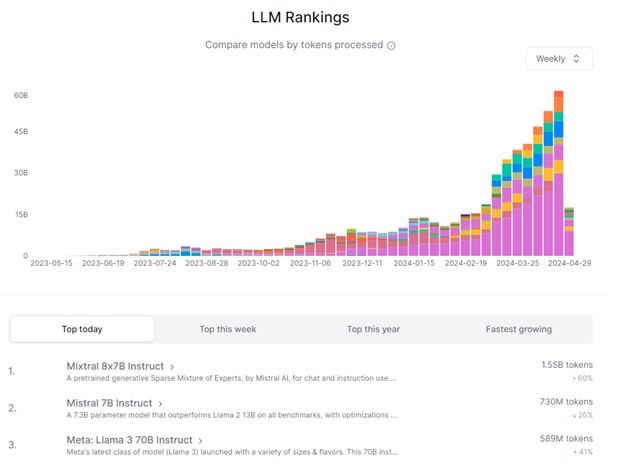

よく使われているLLMランキング

OpenRouterというサイトで、よく使われているLLMのランキング情報を出しています。

これによると、2024年、もっとも使われているLLMのランキングは以下の通り。

- MythoMax 13B

- Mixtral 8x7B Instruct

- Mistral 7B Instruct

- Anthropic: Claude 3 Haiku (self-moderated)

- Mixtral 8x7B Instruct (nitro)

- Mistral Tiny

- Anthropic: Claude 3 Haiku

- OpenChat 3.5

- Google: Gemini Pro 1.0

- Toppy M 7B

- Nous: Hermes 13B

- Mistral 7B Instruct (free)

- lzlv 70B

- MythoMax 13B (nitro)

- OpenAI: GPT-3.5 Turbo

- Anthropic: Claude 3 Sonnet (self-moderated)

- ReMM SLERP 13B

- MythoMax 13B (extended)

- Anthropic: Claude 3 Opus

- Mistral Medium

聞いたことないようなLLMがいっぱい出てる感じです。調べてみると、オープンソース系みたいですね。

あと、トークン数でランキングしているみたいですが、どうやって調べているんだろう…。

LLMのパラメータ数を比較

パラメータ数はLLMの性能や能力を表す重要な指標の一つで、パラメータ数を増やすことでより高度な自然言語処理が可能になります。

単純には言えませんが、LLMの性能をざっくり表せそうな数字です。

| モデル名 | 開発企業 | パラメータ数 |

|---|---|---|

| Claude-3 OPUS | Anthropic | 2兆 |

| GPT-4 | OpenAI | 1.5兆 |

| Gemini | 最大1兆 | |

| Mixtral | Mixtral AI | 1,760億 |

| GPT-3 | OpenAI | 1,750億 |

| BLOOM | BigScience | 1,760億 |

| Grok 1.5 | Grok | 3,140億 |

| Command R+ | Cohere | 1,040億 |

| LLaMA 2 | Meta AI | 最大700億 |

パラメータ数の意味

パラメータ数は、モデルの表現力を示す重要な指標です。パラメータとは、機械学習モデルが学習によって調整する変数のことで、パラメータの数が多いほど、モデルはより複雑な関数を表現できます。

例えば、1,000億のパラメータを持つモデルは、1,000億個のニューロンを持つ人間の脳に例えることができます。

注目すべきポイント

パラメータ数の大小だけでモデルの性能を判断することはできません。以下の要因も重要です:

- 学習データの質と量

- モデルアーキテクチャの効率性

- 特定のタスクへの最適化度合い

特に最近のモデルでは、より少ないパラメータ数でも高い性能を発揮する効率的な設計が注目されています。

LLMと生成AIは違うの?

LLMと生成AIには明確な違いがあり、以下のように整理できます。

定義と範囲の違い

生成AIは、テキスト、画像、音声、動画など、様々なコンテンツを自律的に生成できるAI技術の総称です。一方、LLMは生成AIの一部として位置づけられ、自然言語処理に特化したモデルです。

特徴の違い

データ処理の範囲

- LLMは主にテキストデータの処理と生成に特化しています

- 生成AIはマルチモーダル対応が可能で、異なる形式のデータを統合して処理できます

具体的な活用例

LLM:

- チャットボット

- 文章要約

- 翻訳

- 質問応答

生成AI:

- 画像生成(DALL-E)

- 音声生成

- 動画作成

- テキスト生成

技術的な特徴

LLMは膨大なテキストデータと高度なディープラーニング技術を用いて構築された自然言語処理モデルです。生成AIは、GANやVAEなど、様々な技術を用いて多様なコンテンツを生成することができます。

違いは?

つまり、LLMは生成AIの中の1つのカテゴリーで、テキストデータを扱うのに特化しているのに対し、生成AIはテキスト以外にも画像や音声など、より広い範囲のコンテンツ生成を行うAI技術の総称と言えます。

LLMはテキストの理解と生成に長けていますが、画像生成などはできません。一方、生成AIの中にはStable DiffusionやDALL·E 3のように画像生成に特化したものもあります。

このように、LLMは生成AIの一部であり、より限定的な役割を担っていると言えるでしょう。生成AIの活用範囲はLLMよりも広いですが、その分野の1つとしてLLMが重要な位置を占めているのです。

LLMの種類

大規模言語モデル(LLM)には様々な種類があります。主なLLMを紹介します。

GPT-4

OpenAIが2023年にリリースしたLLMです。GPT-3やGPT-3.5と同様に、Transformerアーキテクチャをベースに開発されています。GPT-4をベースとしたマルチモーダルモデル「GPT-4V」では、画像や音声データも解析できます。

関連 ChatGPTの使い方

PaLM

GoogleのAIチャットボット「Bard」のベースとなるLLMです。GPT-4同様、Transformerを基に開発されました。パラメータ数は5,400億個と非常に大規模です。

llama

2023年2月にMetaが発表したLLMです。パラメータ数は70億、130億、330億、650億個の4種類があります。他のモデルに比べパラメータ数が少ないのが特徴で、オープンソースとしてGitHubで公開されています。

Transformer

2017年に発表された、LLMにつながるきっかけとなったニューラルネットワークアーキテクチャです。現在の多くのLLMの基礎となっています。

関連 Transformerとは何か? 「ChatGPT」や「Gemini」を生み出した超重要技術の進化 |ビジネス+IT

BLOOM

BigScience Workshopによって開発された、1760億のパラメータを持つオープンソースのLLMです。

有名企業が独占してきたLLMに対抗すべく作られたオープンソース版LLMですが、あまりパッとせず。

2022年7月時点で、モデルの更新が止まっているようです。

関連 bigscience/bloom · Hugging Face

他にもClaude、NeMo、OpenCALMなど様々なLLMが存在します。LLMは日々進化しており、より大規模で高性能なモデルが次々と発表されています。